Flash Pool とは

HDD と SSD が混在したアグリゲートを構成し、使用頻度の高いデータを SSD のキャッシュへ集めることで、HDD へのアクセスを低減する機能になります。データを移動させるわけではなく、アクセス頻度の高いデータを ONTAP が自動で判別し、キャッシュされる事から、運用稼動は発生しません。

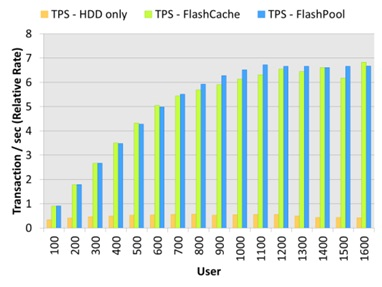

下記は、ユーザ数の増加に伴うスループットの傾向です。(出典:Tech OnTap)

HDD のみで構成した場合、100ユーザの時点で HDD がボトルネックになり、スループットが頭打ちになっています。これに対して、Flash Pool を使用した場合は、ユーザの増加に伴い、スループットが向上しています。

Flash Pool の設定方法

ONTAP シミュレータで SSD Disk を擬似的に作成し、Flash Pool をを設定する際の手順になります。

SSD Disk の作成

- Unlock the Diag user(7-Mode)

> priv set diag *> useradmin diaguser unlock *> useradmin diaguser password

- Unlock the Diag user(Clustered Mode)

> set diag *> security login unlock -username diag -vserver cluster1 *> security login password -username diag -vserver cluster1

- Enter system shell(7-Mode)

*> systemshell login: diag Password: %

- Enter system shell(Clustered Mode)

*> systemshell -node cluster1-01 login: diag Password: %

- Create SSD Disks(7-Mode/Clustered Mode)

% setenv PATH /sim/bin:$PATH % cd /sim/dev % sudo vsim_makedisks -t 35 -a 2 -n 14 % exit

- Vefify the Disks(7-Mode)

*> disk show -n *> sysconfig -r

- Vefify the Disks(Clustered Mode)

*> disk show -container-type unassigned *> system node run -node cluster1-01 sysconfig -r

- Assign the Disks(7-Mode)

> disk assign v6.16

- Assign the Disks(Clustered Mode)

> disk assign -disk v6.16 -owner cluster1-01

Flash Pool の有効化

- Enable the Flash Pool(7-Mode)

> aggr options aggr1 hybrid_enabled on > aggr add aggr1 -T SSD 14

- Enable the Flash Pool(Clustered Mode)

> storage aggregate modify -aggregate aggr1 -hybrid-enabled true > aggregate add-disks -aggregate aggr1 -disktype SSD -diskcount 14

- Use the Flash Pool(7-Mode)

> vol create myvol aggr1 1g

- Use the Flash Pool(Clustered Mode)

> volume create -vserver svm-01 -aggregate aggr1 -volume myvol -size 1g